Capítulo 4 Procesamiento de las fuentes de información y generación de la MPR

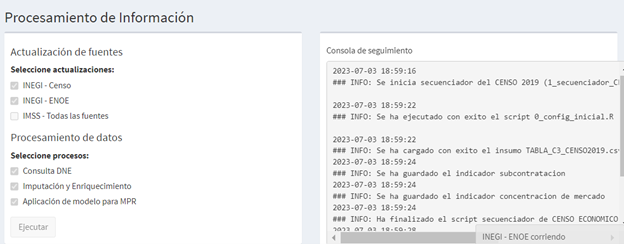

Como ya fue mencionado, en los módulos I y II se procede a la actualización de indicadores a partir de la explotación de las fuentes de información, así como a la consulta del universo de CT, la imputación de indicadores a este universo y la predicción de riesgo que incorpora los resultados del modelo entrenado. En esta sección veremos en detalle cómo funcionan estos dos módulos fundamentales del SIDIL.

4.1 Módulo I: actualización de indicadores

Propósito

El propósito de este módulo es explotar las diferentes fuentes de información para la obtención de indicadores que luego servirán de variables de entrada al modelo predictivo.

EL SIDIL requiere mantener actualizado el conjunto de indicadores laborales porque es la información que se le atribuye o imputa de diferentes formas al universo de centros de trabajo para construir su perfil de riesgo en las diferentes submaterias de interés. Por su enfoque en la información más reciente disponible, a este módulo también se le denomina “coyuntural” y constituye la oferta de información.

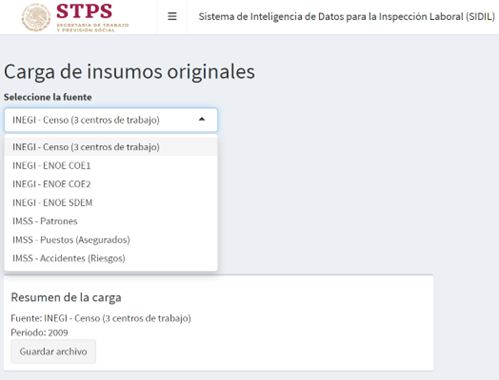

Para cumplir con dicho propósito el SIDIL actualmente contempla la explotación de tres fuentes de información externas a la STPS:

La Encuesta Nacional de Ocupación y Empleo (ENOE y ENOE Nueva Edición).

Los registros de los trabajadores asegurados, patrones y accidentes reportados al IMSS.

El Censo Económico, en su edición del año 2019.

Requisitos para la ejecución de este módulo

Para la ejecución de este módulo no es necesario tener instalado Python, porque únicamente se utiliza R y R Studio.

4.1.1 Desafíos al tratamiento de bases de datos externas

Hay diversos desafíos que se pudieran presentar para la inclusión de bases de datos externas, o para la explotación de indicadores específicos de dichas bases.

Recuadro 4.1: Aspectos a considerar al ejecutar los scripts en los módulos I

Aquí se mencionan los principales desafíos y posibles formas de atenderlos:

Cambios de nombres de variables y variables faltantes: a lo largo del tiempo, con o sin cierta ciclicidad, existen modificaciones en los nombres de los campos de interés en las bases que se explotan. En el caso del IMSS, por ejemplo, el campo registro solía llamarse cve_registro y antes cve_patronal. En el caso de la ENOE, el mismo nombre de variable representa dos conceptos distintos según se trate del primer trimestre o alguno de los restantes tres. A tal efecto, el SIDIL contempla un catálogo de campos que permitan asociar diferentes nombres al mismo concepto. Ver sección Catálogos de información.

Cambios en la utilización esperada de variables: Tal es el caso de los factores de expansión y sus ajustes conforme al censo poblacional: Con la nueva edición de la ENOE, se implementaron nuevos factores de expansión y variables muestrales para ajustar el diseño muestral de la encuesta conforme al nuevo censo de población. Esto hizo que, a partir del tercer trimestre de 2020 cambiaran las variables de diseño muestral de la encuesta. En el análisis coyuntural del SIDIL están considerados los nuevos nombres de variables muestrales, mientras que en el análisis histórico se toma en cuenta el cambio a partir del 2020. Si volviera a ocurrir un cambio en estas variables, bastará con cambiar el nombre de la misma en el catálogo correspondiente, como se señaló en el punto anterior. Por otra parte, este cambio del diseño muestral también ha propiciado cambios en las bases de años anteriores de la ENOE. La versión del SIDIL llega hasta la actualización realizada por el INEGI del 20 de febrero de 2023 en la cual se reemplazaron los archivos de las bases de datos de los cuatro trimestres de 2014. Si se desea, se puede actualizar el análisis histórico cuando se tengan disponibles las bases actualizadas del año 2013 y 2012.

Imposibilidad de acceso a un periodo de referencia: En el caso del IMSS este problema se exacerba porque para el cálculo de los indicadores siempre es necesario combinar diferentes tipos de insumos: por ejemplo, el cálculo de tasa de prevalencia de asegurados percibiendo hasta un 5% por encima del salario mínimo vigente requiere la unión del insumo puestos con el insumo de patrones registrados. La falta de uno de estos tipos (por ejemplo, puestos) imposibilita el cálculo del periodo de referencia. En cambio, sí sería posible calcular los indicadores que requieren de accidentes y patrones si ambos estuvieran disponibles. En cambio, en el caso de la ENOE típicamente las diferentes tablas que se requieren para la actualización de un periodo de referencia vienen juntas en un mismo archivo comprimido, por lo que, si éste no está disponible, todos los indicadores para ese periodo de referencia no podrían ser calculados.

Inclusión de nuevos indicadores. El diseño del SIDIL contempla la posibilidad de incluir nuevos indicadores con relativa facilidad, siguiendo el procedimiento estipulado en el recuadro a continuación. Es importante mencionar que la incorporación de nuevos indicadores, de requerirse su inclusión como variables de entrada para la predicción de riesgo, requiere el re-entrenamiento del modelo. Sin embargo, si sólo hubiera necesidad de incorporarlos como un indicador adicional para la caracterización “unidimensional” de un CT, entonces no es necesario volver a entrenar el modelo.

Ajustes al cálculo de indicadores: Hay que distinguir la necesidad de la inclusión de nuevos indicadores que se especificó en el punto y recuadro anterior. Un cambio en la metodología de cálculo de un indicador no requiere mayor modificación que resguardar el script del cálculo del indicador con una fecha de versión posterior a la más reciente hasta entonces. Así el secuenciador de la explotación de la fuente de información detectará que esta es la nueva versión que se debe tomar. Por supuesto, el cálculo debe ser replicado hacia atrás en el tiempo para asegurar la consistencia temporal de la medición de indicadores.

Recuadro 4.2: Procedimiento para la inclusión de nuevos indicadores

Para calcular un nuevo indicador es necesario seguir el siguiente procedimiento, asumiendo que ya está definida la pertinencia, metodología de cálculo y asegurada la disponibilidad de las fuentes de información necesarias. Supongamos el siguiente ejemplo: se requiere calcular la tasa de accidentes por trabajador asegurado que concluyeron con la incapacidad permanente o defunción de la/el asegurada/o. Llamémoslo tasa_incapp_def

- Es necesario revisar si se requiere recuperar información desde el script de Extracción Selección y Transformación: En este caso, es necesario, desde este script, generar una variable que refleje la cuenta de accidentes/riesgos que terminaron en incapacidad permanente por registro patronal. Se realiza durante el procesamiento del insumoAccidentes. Supongamos esto genera la variable num_incapp_defuncion que pudiera resultar del cálculo de la suma del número de riesgos en los casos que el tipo de riesgo es igual a 1 o 3 y la consecuencia es igual a 3 ó 4, ignorando los missing values o valores faltantes. Lo anterior tendría la siguiente sintaxis en lenguaje R:

Group_by(registro) %>%

summarise(num_incapp_defuncion =sum(num_riesgos[(tipo_riesgo==1| tipo_riesgo==3) & (consecuencia==3 | consecuencia ==4)],na.rm=T) %>%

ungroup()- Se define el script de cálculo de indicadores y se lo resguarda en su respectiva carpeta dentro de códigos “2_codigos/xxxx/cod_IMSS/nombre_indicador”. Notar que xxx corresponde a tanto historico como coyuntura (hay que guardarlo en ambas si se quiere que el indicador entre también al modelo predictivo) y nombre_indicador vendría a ser, en este ejemplo tasa_incapp_def. El nombre de la subcarpeta y el nombre del indicador deben coincidir exactamente.

-

Para el desarrollo del script del nuevo indicador se sugiere tomar como base el script del indicador que utilice las mismas fuentes de información, realizando los ajustes específicos y sin alterar aquellas líneas del código que hacen al tratamiento general de los insumos.

-

Notar que siempre, todos los scripts, deben tener una fecha de versión, siguiendo los dígitos de año, mes y día que estipula el principio de versionado (similar al parámetro “v” definido en el script de config_inicial)

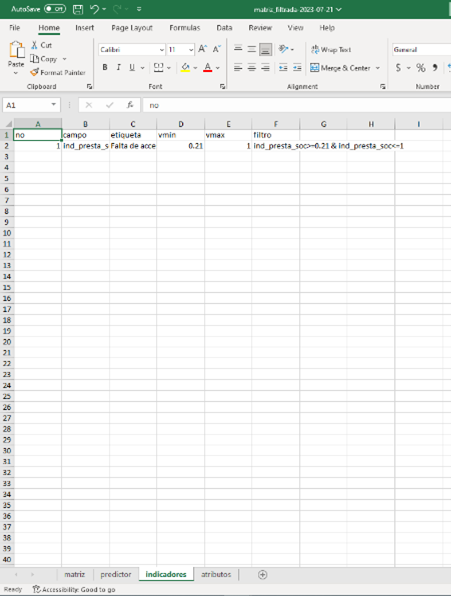

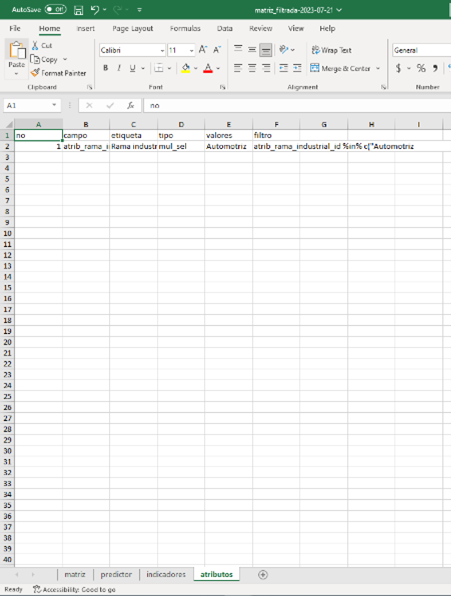

- En el catálogo de indicadores dentro de la carpeta “1_insumos/catalogos/ procesamiento_informacion/indicadores” deben completarse todas las columnas en una nueva fila, respetando exactamente el mismo nombre del indicador y los demás parámetros preestablecidos (hay mucha flexibilidad en cuanto al nivel del coeficiente de variación y etiqueta del indicador, más no tanto en los demás campos, toda vez que los scripts requieren definiciones exactas).

Recuadro 4.3: Distinción entre incorporación de nuevos indicadores y actualización de método de cálculo de indicadores preexistentes

A diferencia de la incorporación de nuevos indicadores, solamente actualizar el método de cálculo de un indicador (por ejemplo, incorporar otra categoría de riesgos para el cálculo de cierta tasa) no requiere incluir una nueva carpeta, etc. Lo único que se requiere es:

-

Abrir el script anterior, la última versión del mismo

-

“Guardar como” con una fecha de versionado posterior a la anterior

-

Realizar las modificaciones

-

Guardar con esa nueva versión posterior.

4.1.2 Sobre niveles de agregación

Los indicadores calculados con todas las fuentes de información no siempre son atribuibles de manera directa a cada uno de los CT identificados nominativamente. Esto es por la propia naturaleza de los datos (censos y encuestas que por confidencialidad no publican información de las personas físicas y morales que responden a sus reactivos), por la falta de registro del patrón laboral en instancias como el IMSS, así como limitaciones en el procesamiento de la información en el DNE. La consecuencia es que los indicadores calculados a partir de las fuentes de información más diversas deben ser atribuidos a los CT a partir de características observables cuando resulta imposible atribuirlo de manera nominativa.

El SIDIL ha contemplado diferentes metodologías de imputación de dichos indicadores. Considerando la frecuencia con la que se realiza este proceso, el contexto administrativo en el que se ejecuta el SIDIL y la necesidad de transparencia de este proceso, se ha optado por atribuir los indicadores calculados a los CT a partir de la conjunción de tres características o dimensiones que pueden ser observados de manera completa o incompleta en los CT, según cada caso particular.

Estas características o dimensiones son:

Su ubicación geográfica, pudiendo especificarse en dos diferentes niveles:

- a nivel entidad (campo geo2) y

- a nivel municipio/alcaldía (campo geo5)

Su actividad principal, siguiendo el Sistema de Clasificación Industrial de América del Norte (SCIAN), y pudiendo especificarse en dos diferentes niveles:

- SCIAN a dos dígitos (campo scian2018_2) y

- SCIAN a tres dígitos (campo scian2018_3)

El tamaño del centro de trabajo. 4

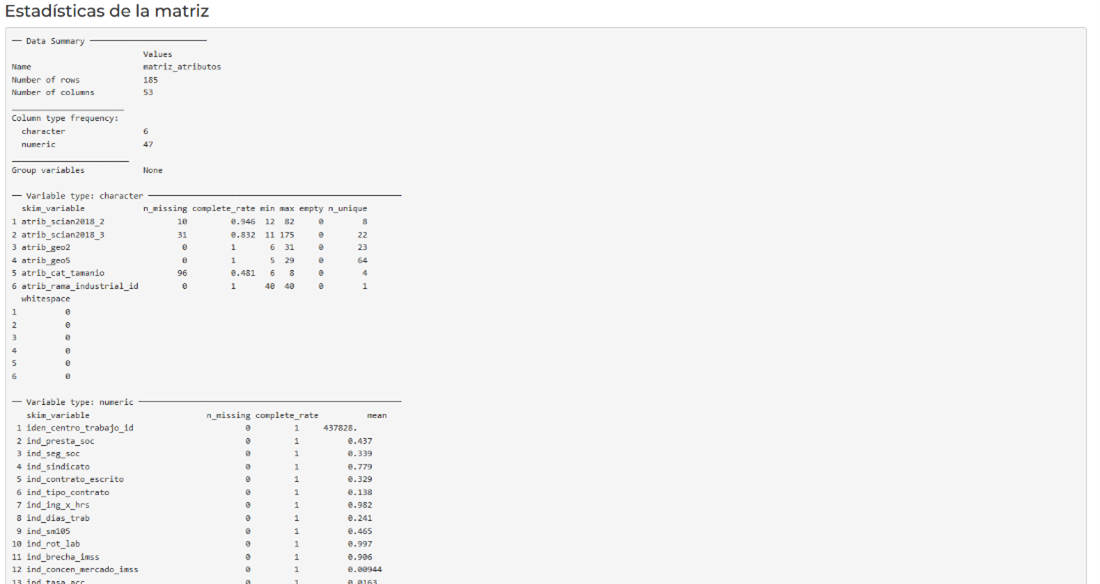

Al ejecutar los scripts que desarrollan los indicadores de cada una de las fuentes de información se obtiene una tabla específica para cada indicador por fuente de información por periodo de referencia que incluye la siguiente información: los campos de dimensiones de niveles de agregación (cat_tamanio, geo2, geo5, scian2018 y_2, scian2018_3), campos de agregación (agregacion (etiqueta del nivel), agregacion_numerica, grupo_calidad_info1, grupo_calidad_info2, indicador, script_calculo, fecha_calculo, usuario, valor, cv, periodo).

Para no duplicar información en este manual, se deja al lector consultar en la sección Catálogos de información, la clasificación de los atributos que se encuentra en dichos catálogos.

En la gráfica a continuación se observa un ejemplo de cómo se pueden distribuir las estimaciones puntuales calculadas en los diversos niveles de agregación disponibles para una fuente de información, en este caso, la ENOE, y con relación al coeficiente de variación de dichas estimaciones puntuales.

Recuadro 4.4: Modificaciones a los niveles de agregación

La inclusión de nuevas fuentes de información, o cambios sustantivos a las existentes, podría causar la necesidad de revisar los niveles de agregación. Es altamente improbable que esto ocurra, sin embargo, los pasos serían los siguientes:

-

Redefinir el catálogo de niveles de agregación.

-

En el script de configuración inicial, ajustar la lectura y definición de los niveles de agregación.

- Los niveles de agregación van numerados: agregacion_01, agregacion_02, etc. mismos que se generan como parámetros individuales y luego se agrupan en una lista. Se sugiere no modificar la numeración para que no sea necesario ajustar los scripts de los indicadores que recorren dichos niveles para agrupar las observaciones que cumplan con las categorías incluidas en ellos.

-

Revisar los scripts de matching, tanto el coyuntural como el histórico, toda vez que potencialmente habría más variables.

-

Revisar la especificación de la interfaz de consulta para que refleje posibles variaciones en el número o composición de las dimensiones escogidas.

4.1.3 Sobre estimaciones puntuales nominativas

Los registros administrativos del IMSS permiten generar información específica para un centro de trabajo que es identificado de manera unívoca a través de su clave patronal. Esta información tan específica es de mucha utilidad para la caracterización fidedigna de los CT en el DNE.

Cabe cuestionarse que tanto para la imputación de estimaciones puntuales nominativas como para el enriquecimiento de atributos de geografía, tamaño y clasificación industrial, sería deseable incorporar un segundo campo a la “llave” entre los datos del DNE y los nominativos del IMSS. Esto para evitar posibles imputaciones equivocadas. Se han realizado pruebas incluyendo el número de código postal como campo adicional a la clave patronal, sin embargo, dicha inclusión vuelve demasiado restrictiva la imputación nominativa, es decir, son demasiado pocos los CT del DNE que se pueden asociar al universo de patrones del IMSS. En números redondos, en lugar de imputarle a más de 170 mil CT del DNE información del IMSS, al incluir el código postal, se reduce a cerca de 50 mil registros.

Conforme se profundice la aplicación del SIDIL y se realicen las mejoras planeadas al DNE, convendría revisar nuevamente el criterio de imputación nominativa.

Gestión de archivos de estimaciones puntuales por fuente de información

Como se observa en la sección de Estructura y flujos de trabajo, la estructura de carpetas prevé una carpeta para cada indicador. A su interior, a su vez se incluye una subcarpeta llamada anteriores misma que permite almacenar los outputs de procesos anteriores.

Recuadro 4.5: Organización de las estimaciones puntuales por indicador

Todos los cálculos de indicadores concluyen generando un único archivo en formato .Rds que reúne todas las estimaciones puntuales para todos los niveles de información, habiendo una tabla para cada indicador, fuente de información y periodo. Cabe notar que el algoritmo de matching coyuntural que recupera la información de estos outputs selecciona únicamente el output de cada indicador según la fecha de creación (parámetro v) más reciente, independientemente de que esté resguardo en la subcarpeta anteriores o en un nivel superior. Incluso lo detectaría si estuviera en la carpeta a un nivel mayor (por ejemplo, res_coy_ENOE o res_coy_IMSS). Es decir, mover los indicadores a la subcarpeta anterior únicamente es a fin de facilitar la organización de los archivos (para la inteligibilidad humana), más no tiene afectaciones en la ejecución del código.

Tratamiento de industrias manufactureras, transportes, correo y almacenamiento

Todos los indicadores, independiente de su fuente de información, se calculan para las diversas combinaciones posibles de las diferentes categorías del SCIAN a 2 y 3 dígitos, combinado respectivamente con las categorías de las otras dos dimensiones que constituyen los niveles de agregación (geografía y tamaño). En el caso del SCIAN 31-33 (industrias manufactureras) y 48-49 (transportes, correos y almacenamiento) se realiza un tratamiento especial. Esto porque, dada la cantidad de subsectores que tiene, el SCIAN utiliza los sectores 31, 32 y 33 para agrupar todos los subsectores de las industrias manufactureras, y el 48 y 49 para transportes, correos y almacenamiento.

Pero, en sentido estricto, cuando un usuario final quiere obtener el valor de una estimación puntual representativa para uno de estos dos grandes sectores, no quiere preocuparse por su codificación, sino que busca obtener un único valor representativo para todo el sector, sin importar si a dos dígitos sería el 31 o 32 o 33. Es decir, el promedio del sector industria manufacturera, debe ser el mismo independientemente de que el subsector (actividad, rama… ) estén finalmente agrupados bajo el identificador 31, 32 ó 33. Lo análogo, por supuesto, con transportes, correos y almacenamiento. A tal fin se realiza el siguiente procedimiento.

Previo a la estimación puntual de un indicador, el campo scian2018_2 se uniforma a 31 si el campo scian2018_3 comienza con 32 o 33.

Cuando el nivel de agregación que se calcula excluye el scian2018_3 pero incluye el scian2018_2 (por ejemplo, un nivel de agregación “2_geo2_act2”) entonces el cálculo de los sectores 31 y 48 en realidad están también incluyendo las observaciones que se clasifican como 32 y 33 ó 49, respectivamente.

Finalizado el cálculo de los indicadores, se replican los resultados obtenidos para las categorías 31 y 48 para incluir nuevas observaciones (sólo para los niveles de agregación que incluyen scian2018_2 pero no scian2018_3) con los número 32, 33 y 49, respectivamente.

4.1.4 Especificaciones por fuente de información

Esta sección reúne información relevante en dos niveles. Por un lado, se ofrecen detalles de los indicadores que se calculan para cada una de las fuentes de información. Por otro lado, se informan los procedimientos de cálculo de dichos indicadores y aspectos que requieren mayor cautela. A continuación, primero se presenta el resumen de las otras subsecciones que siguen. Se observa que la gran mayoría de las fuentes información son de carácter administrativo. Las excepciones vienen de la ENOE y del CENSO gestionadas por INEGI.

Fuente | Responsable de producción | Acceso | Tipo de fuente | Frecuencia de actualización |

|---|---|---|---|---|

DNE | STPS | Interno | Administrativoa | Diaria |

SIAPI/SIPAS* | STPS | Interno | Administrativo | Diaria |

Asegurados en el IMSS | IMSS | Confidencial, sólo estadísticas agregadas | Administrativo | Mensual |

Patrones en el IMSS | IMSS | Confidencial, sólo estadísticas agregadas | Administrativo | Mensual |

Accidentes reportados al IMSS | IMSS | Confidencial, sólo estadísticas agregadas | Administrativo | Semestral |

ENOE | INEGI | Público | Encuesta | Trimestral |

Censo Económico | INEGI | Interno | Censo (Tabla generada en colaboración INEGI-DGIET(STPS)) | Quinquenal |

aLos detalles de las fuentes de informacion se presentan en el Modulo II | ||||

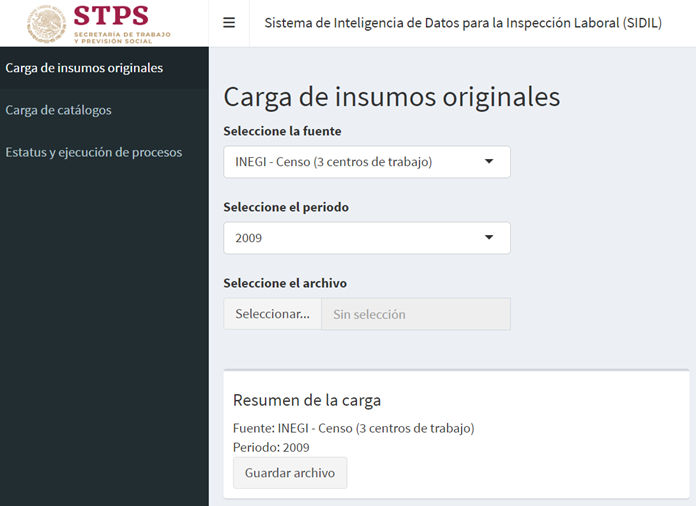

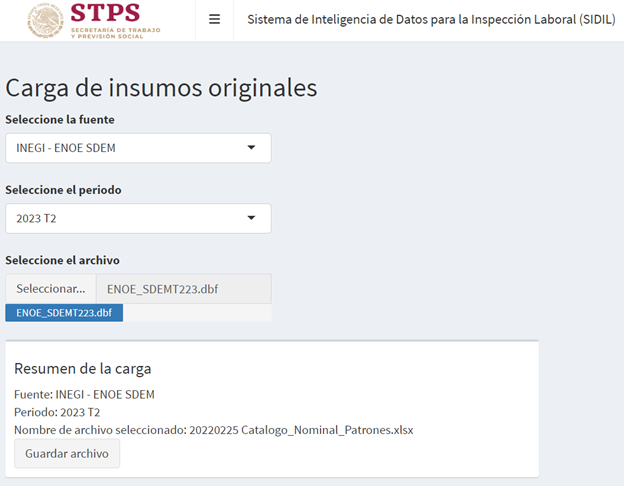

Todas estas fuentes de información se incorp oran y deberán seguir incorporándose conforme surjan actualizaciones futuras, en un determinado formato, estructura de nombre, ubicación especifica y frecuencia de actualización. Estas características fundamentales serán especificadas en cada una de las subsecciones siguientes.

Recuadro 4.6: Resguardo de las bases originales

El adecuado resguardo de la información original provista por las fuentes de información es crítico para el funcionamiento del sistema. Algunos puntos importantes a considerar:

- Sintaxis para el nombrado de los insumos. Dado que esta información no se encuentra como campo “dentro” de los insumos, el correcto nombrado del archivo digital es indispensable. AIR ha detectado los patrones más frecuentes de cómo se guardan los diferentes insumos de las diferentes fuentes de información, y esto fue reflejado en los scripts que los utilizan, motivo por el cual no se sugiere modificaciones a la sintaxis (salvo excepciones) sino constancia en los patrones actuales.

- Ubicación de los insumos en las carpetas y subcarpetas adecuadas. El resguardo adecuado del insumo incluye su ubicación en la carpeta adecuada y en el formato especificado, toda vez que los algoritmos detectan el tipo de fuente, el periodo de referencia, etc., a partir de las carpetas, subcarpetas y nombres que se estipulan en el catálogo de fuentes. Resguardo para la reproducibilidad. El SIDIL descansa sobre un versionado de scripts y outputs, resguardando el mínimo de resultados intermedios, para hacer un uso eficiente del almacenamiento a disco. Lo hace bajo el supuesto fundamental de que los insumos se mantendrán disponibles en las carpetas especificadas o al menos resguardados en su formato original en otro lugar, pero disponibles para ser nuevamente colocadas en su carpeta específica para reproducir una determina actualización.

- No duplicidad de insumos para un mismo periodo de referencia: no se debe guardar más de un archivo para un mismo insumo de un determinado periodo de referencia. Esto también aplica aunque fueran en formatos distintos: sólo puede haber un insumo para un periodo de referencia dentro de la carpeta especificada.

4.1.4.1 La ENOE

La Encuesta Nacional de Ocupación y Empleo (ENOE y ENOE Nueva Edición) brinda información de manera trimestral sobre el mercado laboral mexicano. Esta encuesta es representativa a nivel entidad federativa.

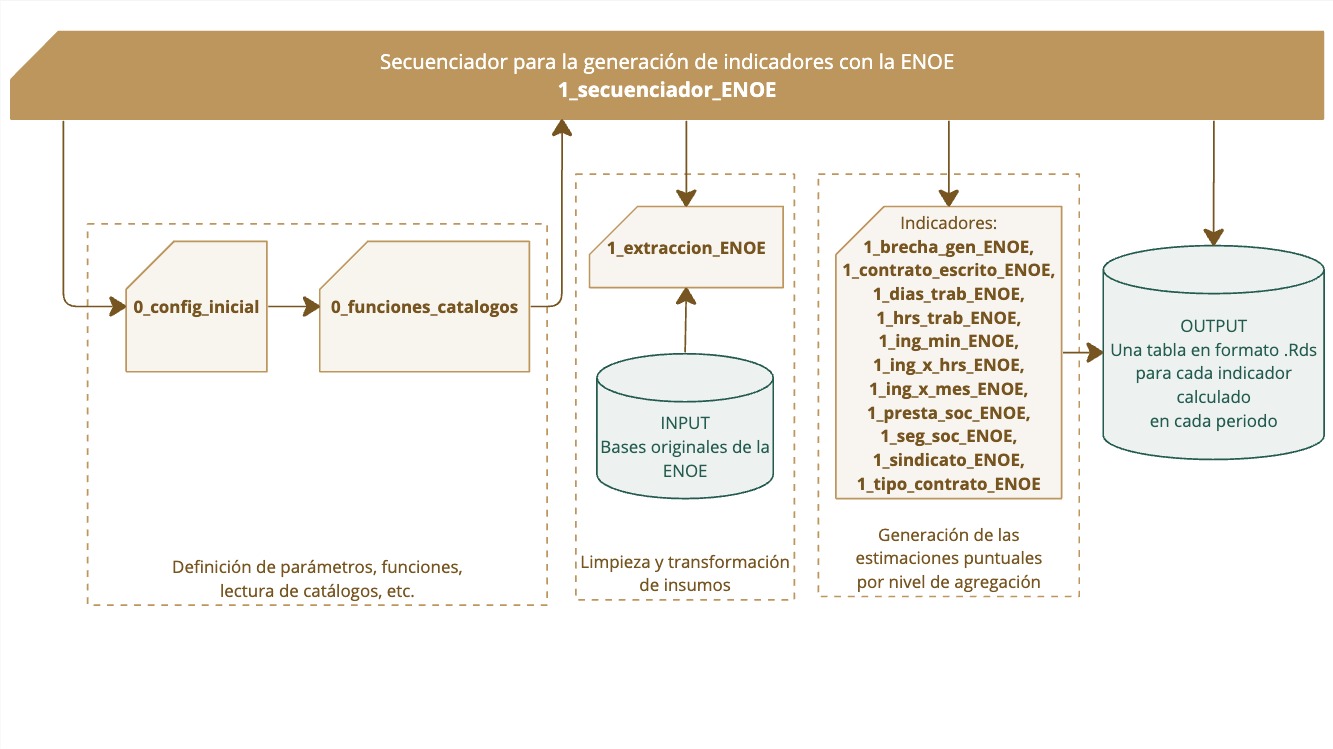

A partir de esta fuente de información se calculan diversos indicadores laborales que servirán para carcterizar a los centros de trabajo. En la siguiente ilustración se detalla el proceso de aplicación de scripts para la generación de indicadores coyunturales de la ENOE. El scrit secuenciador ejecuta los procesos de configuración incial, de limpieza y transformación de insumos originales, y de generación de estimaciones puntuales de cada indicador, para generar, finalmente, los outputs del cálculo de indicadores.

En esta sección se brinda ingormación detallada sobre este proceso.

Recuadro 4.7: Aplicación de scripts de la ENOE

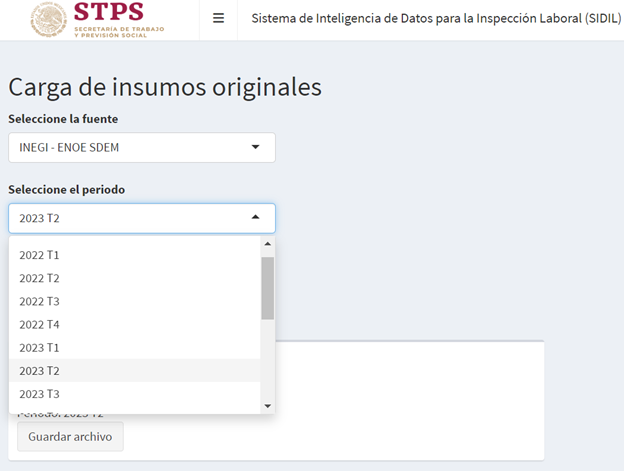

Frecuencia de actualización y propuesta de calendarización

La ENOE cuenta con cinco tablas, de las cuales se utilizan tres para generar 11 indicadores en 11 niveles de agregación. Las tablas son: 1) Tabla con los datos sociodemográficos (SDEM), 2) Tabla de cuestionario de ocupación y empleo I (COE1) y, 3) Tabla de cuestionario de ocupación y empleo II (COE2). El INEGI aplica un cuestionario básico en los trimestres dos, tres y cuatro de cada año, y un cuestionario ampliado en el primer trimestre. El cuestionario ampliado es el que permite a SIDIL estimar una tasa de sindicalización, mismo que no es posible hacer en los trimestres restantes.

Estas bases de datos de la encuesta se actualizan de manera trimestral, por lo cual esa será la frecuencia de actualización. Si bien la STPS recibe las bases de la ENOE por parte del INEGI de manera directa y con cierta anticipación de su publicación (y son las bases que utiliza el SIDIL), no es necesario ejecutar la actualización de inmediato, sino que se puede tomar como guía el calendario de publicaciones de INEGI5, las próximas publicaciones de la ENOE desde la realización de este manual son: segundo trimestre 2023: 28 de agosto de 2023 y tercer trimestre 2023: 27 de noviembre de 2023.

Por supuesto, la DGIET debe estar atenta a modificaciones en este calendario, así como de las actualizaciones previstas para 2024 y a posteriori.

Se sugiere que la actualización de los indicadores de la ENOE se realice con cada actualización de la encuesta, y durante las dos semanas siguientes de la publicación de la encuesta. Esto sujeto a cambios en la calendarización de la publicación de la ENOE.

Indicadores que se calculan

Con la ENOE se calculan once indicadores, de los cuales para diez la información se encuentra disponible de manera trimestral y uno con frecuencia anual. En la siguiente tabla se muestra el detalle de los indicadores. Notar que todos los indicadores, incluidos los de la ENOE, antes del entrenamiento del modelo predictivo (módulo IV) y de la predicción del mismo (módulo II) se estandarizan entre 0 y 1 e invierten para expresar que “más es peor”, es decir, un mayor percentil de un indicador se asocia a peores condiciones laborales:

Indicador | Descripción | Frecuencia de cálculo |

|---|---|---|

Días trabajados | Promedio de días trabajados de personas trabajadoras subordinadas y remuneradas. | Trimestral |

Horas trabajadas | Promedio de horas trabajadas de personas trabajadoras subordinadas y remuneradas. | Trimestral |

Acceso a prestaciones sociales | Promedio de personas trabajadoras subordinadas y remuneradas con al menos una prestación social: vacaciones, aguinaldo y reparto de utilidades (sin considerar acceso a servicios de salud) | Trimestral |

Acceso a seguridad social | Promedio de personas trabajadoras subordinadas y remuneradas con acceso a instituciones de salud | Trimestral |

Contrato escrito | Promedio de personas trabajadoras subordinadas y remuneradas con contrato escrito | Trimestral |

Tipo de contrato | Promedio de personas trabajadoras subordinadas y remuneradas por tipo de contrato: de base/planta/tiempo indefinido o temporal. | Trimestral |

Ingreso laboral por mes | Promedio de ingreso por mes de personas subordinadas y remuneradas. | Trimestral |

Ingreso laboral por hora | Promedio de ingreso por hora de personas trabajadoras subordinadas y remuneradas. | Trimestral |

Salario mínimo | Porcentaje de personas trabajadoras subordinadas y remuneradas que perciben hasta un salario mínimo | Trimestral |

Igualdad salarial | Brecha de ingresos (promedio simple) entre personas trabajadoras subordinadas y remuneradas. | Trimestral |

Tasa de sindicalización | Porcentaje de personas trabajadoras subordinadas y remuneradas que pertenecen a un sindicato | Anual (con la base del primer trimestre de cada año) |

El cálculo de los indicadores se realizará en las 11 agregaciones, las cuales consideran todas las combinaciones de los siguientes niveles: nivel nacional (geo0), entidad federativa (geo2), tamaño del centro de trabajo (cat_tamanio), clasificación industrial SCIAN a dos y tres dígitos (scian2018_2 y scian2018_3, respectivamente).

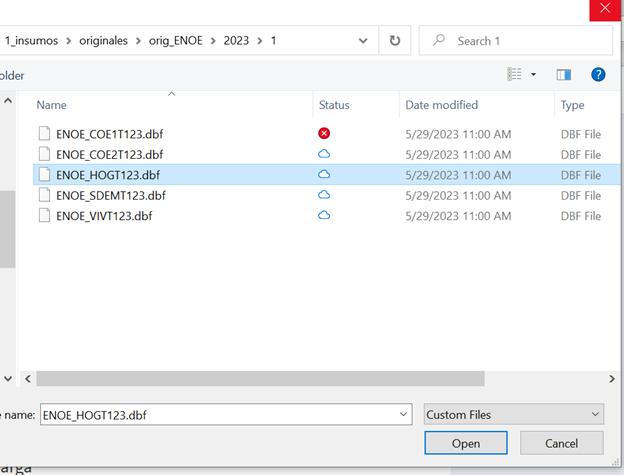

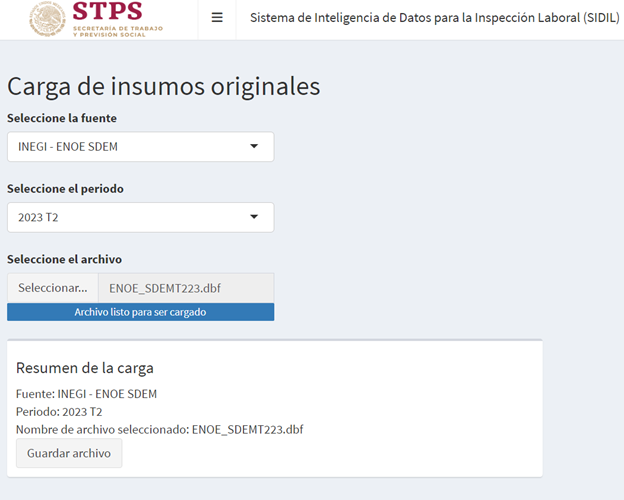

Entradas - Inputs

Los insumos principales para la generación de los 11 indicadores son las bases de datos originales de la ENOE que son proporcionadas por el INEGI a la DGIET de la STPS o bien, las bases descargadas del sitio oficial del INEGI en formato .dbf.

La estructura del nombre de los archivos puede presentarse de la siguiente manera;

ENOEN_COE1(trimestre del 1 al 4) T(últimos dos números del año)_2x.dbf

- Ejemplo: ENOEN_COE1T222_2x.dbf

ENOEN_COE2(trimestre del 1 al 4) T(últimos dos números del año)_2x.dbf

- Ejemplo: ENOEN_COE2T222_2x.dbf

ENOEN_SDEM (trimestre del 1 al 4) T(últimos dos números del año)_2x.dbf

- ENOEN_SDEMT222_2x.dbf

(Notar que todas las bases de datos de datos deben estar en formato .dbf)

Aunque la estructura del nombre puede variar, es importante que el nombre contega los siguientes elementos para que sean detectados por el script extractor: nombre del cuestionario (COE1, COE2 o SDEM), un dígito para el trimestre, seguido por una T, seguido por dos dígitos para el año, y finalizar con el formato .dbF.

Se utilizan estas bases para seguir los principios de uso mínimo de memoria de las computadoras y de aprovechamiento de los recursos ya disponibles por la Secretaría, por lo que esta estructura se establece siguiendo la estructura real de los archivos al momento de ser entregado este manual. Si esta estructura cambia, es imprescindible que los archivos se guarden con nombres que sigan la estructura anteriormente expuesta en orden de que se puedan leer los archivos y generar los indicadores.

Adicionalmente, para la explotación correcta de la ENOE se utilizan catálogos de los siguientes tipos:

De clasificación industrial

De nombres de campos (homologación de nombres de variables)

De indicadores

Aplicación de scripts

Para la generación de los 11 indicadores de la ENOE se cuenta con tres tipos de scripts en lenguaje R:

Script secuenciador (1script): Este script secuenciador inicia con la definición de tres objetos: 1)sinkmode: que si es igual a TRUE (verdadero) genera y guarda el log en un archivo “.txt”; 2) val_referencia: que si es igual a TRUE genera una tabla que compara las estimaciones puntuales generadas con las realizadas de manera histórica para ciertas agregaciones; y 3) muestra: que si es igual a verdadero o TRUE toma solo una muestra de la base del scirpt de transformación, esta opción es útil para probar cambios en los scripts. Para el funcionamiento habitual del script, los objetos se entregarán definidos de la siguiente manera: sinkmode=TRUE; val_referencia=TRUE y muestra=FALSE-. El script llama y corre el script de configuración inicial, así como a todos los scripts descriptos en esta sección. El script inicia con el llamado y ejecución del script de configuración e inicia la escritura del log. Posteriormente llama y ejecuta el script de extracción y transformación, de donde toma la definición del periodo y del año. Al finalizar cada ejecución de los scripts da un mensaje de confirmación o de error de estos procesos. Luego, genera un mensaje donde se muestra el periodo y el año que se utilizarán para el cálculo de los indicadores, llama y ejecuta los 11 scripts de los 11 indicadores, dando un mensaje de confirmación o error al culminar cada proceso. Finalmente, cierra la escritura del log y genera un sonido que indica que ya ha terminado todo el proceso.

Script de transformación (1 script): Este script extrae y transforma las bases de datos de insumos principales (referidas en la sección anterior) para generar una sola base de datos con la información necesaria para el cálculo de los indicadores. Primero, crea una lista de los archivos disponibles en la carpeta de insumos originales de la ENOE (orig_ENOE), identifica los nombres de los cuestionarios, el trimestre y el año, para posteriormente quedarse únicamente con el último trimestre disponible de los cuestionarios SDEM, COE1 y COE2. Luego, carga estas bases y realiza el pegado de los cuestionarios. Finalmente, cambia los nombres de las variables clave para las agregaciones, filtra la base quedándose únicamente con la población objetivo, aplica funciones para identificar las variables que se utilizarán para los indicadores según el trimestre que se haya cargado y cambia su nombre6. La base de resultados contiene la información relativa a la población trabajadora subordinada y remunerada durante el periodo de referencia. Para minimizar el uso de la memoria en disco, esta nueva base de datos generada no se guarda en la memoria de manera permanente. El mensaje que indica la culminación de este script señala que se ha generado la base de datos de población trabajadora subordinada y remunerada para determinado periodo y año, mostrando el total de hombres y mujeres de esta población. Este mensaje de cierre es de utilidad para confirmar que se ejecutó el script para el periodo y año correcto, además de que el pegado y manipulación de las bases fue el correcto (por medio del número de la población de mujeres y hombres trabajadores subordinados y remunerados).

Scripts de generación de indicadores (11 scripts): Estos scripts toman la base transformada para generar cada uno de los indicadores (un script por indicador) con sus respectivas estimaciones puntuales para los diferentes niveles de agregación que aplica a la fuente de información. Primero, se crea o modifica la variable objetivo del indicador, para posteriormente declarar la encuesta. Luego, se emplea un loop para calcular el indicador a lo largo de las estimaciones correspondientes, y calcular la agregación a nivel 0 (nivel nacional). Finalmente, se crea un solo archivo con todas las agregaciones del indicador, se generan los campos de identificación de cada agregación, y se limpian las estimaciones puntuales quitando los 0 y 1 en el caso de los indicadores que utilizan la media. Estos scripts generan un archivo .Rds cada uno, los cuales posteriormente serán almacenados en la memoria de la computadora o el servidor utilizado con el nombre del indicador y la fecha de generación.

Salidas - Outputs

Los outputs o resultados esperados finales de la aplicación de los scripts de la ENOE son 11 archivos .Rds correspondientes a cada uno de los 11 indicadores para un periodo de referencia, los cuales contienen las estimaciones puntuales de los indicadores en los (coincidentemente) 11 niveles de agregación para el último periodo disponible.

Estas estimaciones puntuales coyunturales serán el insumo del matching coyuntural, y serán imputadas a los CT según el nivel de agregación correspondiente a la información disponible de cada centro de trabajo.

4.1.4.2 Registros administrativos del IMSS

La incorporación de las tablas de registros administrativos que el IMSS comparte con la STPS es una muy importante incorporación al SIDIL, dadas las siguientes características de este registro administrativo:

Su elevado nivel de cobertura: con tasas de informalidad que rondan el 55% a nivel nacional7 esta información cubre cerca de la mitad de la población trabajadora. Por supuesto que, a diferencia del DNE, los CT registrados en la base de patrones únicamente son los empleadores formales8.

Al ser un registro administrativo cabe remarcar que su propósito no es (primordialmente) la estadística - no surge de una encuesta, no existen parámetros de diseño complejo, por ello la definición y utilidad que tienen los coeficientes de variación de una estimación puntual deben ser interpretados con su debida cautela.

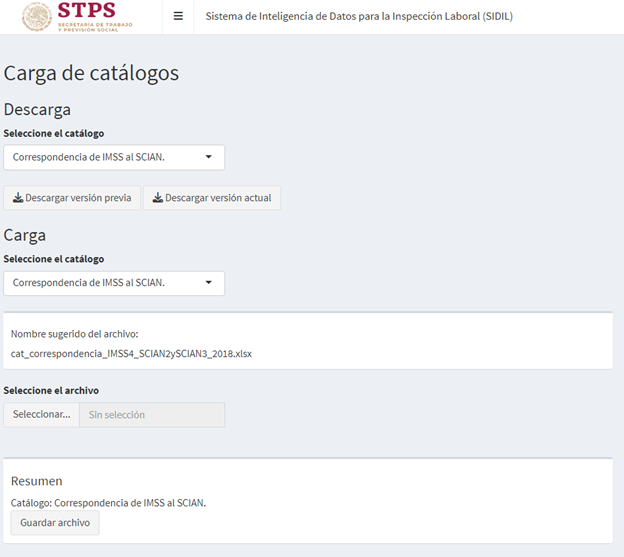

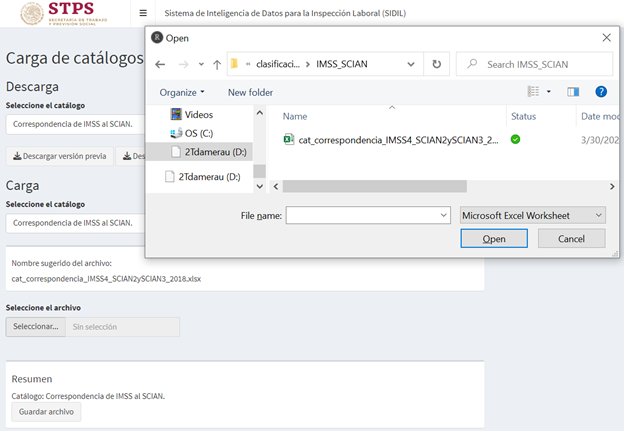

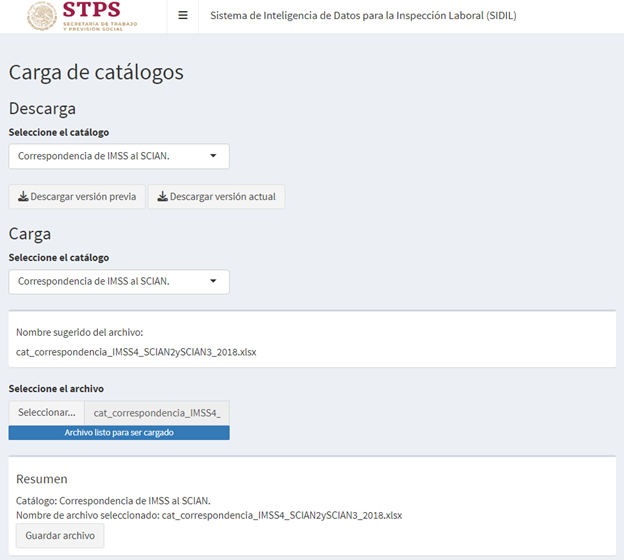

El IMSS utiliza su propia clasificación industrial, misma que no es del todo equivalente a la del SCIAN que se utiliza en estadísticas del INEGI. Para atender a este desafío se desarrolló una tabla de correspondencias unidireccional del IMSS al SCIAN a tres y dos dígitos, misma que fue cotejada y enriquecida con resultados de un trabajo independiente realizado por la propia STPS junto con el INEGI y el IMSS.

Las bases del IMSS contienen registros más voluminosos que las demás fuentes de información utilizadas, ya que la base de patrones es más de un millón de observaciones y la de puestos asegurados, supera los 20 millones de registros, ambas de actualización mensual. Mientras tanto la base de riesgos/accidentes concluye el año reportando aproximadamente medio millón de observaciones.

Por lo anterior, en ciertos procedimientos específicos, como, por ejemplo, el completado del campo de Clave Única de Registro Poblacional (CURP) a partir de un número de seguridad social (NSS), o el cálculo de ciertos indicadores como el de rotación laboral que requiere la construcción de un panel de mes contra mes, se procesa la información total en un conjunto de fracciones (que toman en consideración la memoria RAM disponible en la computadora). Estas fracciones se escriben temporalmente a disco rígido, se vuelven a leer para conformar una única tabla y luego se eliminan.

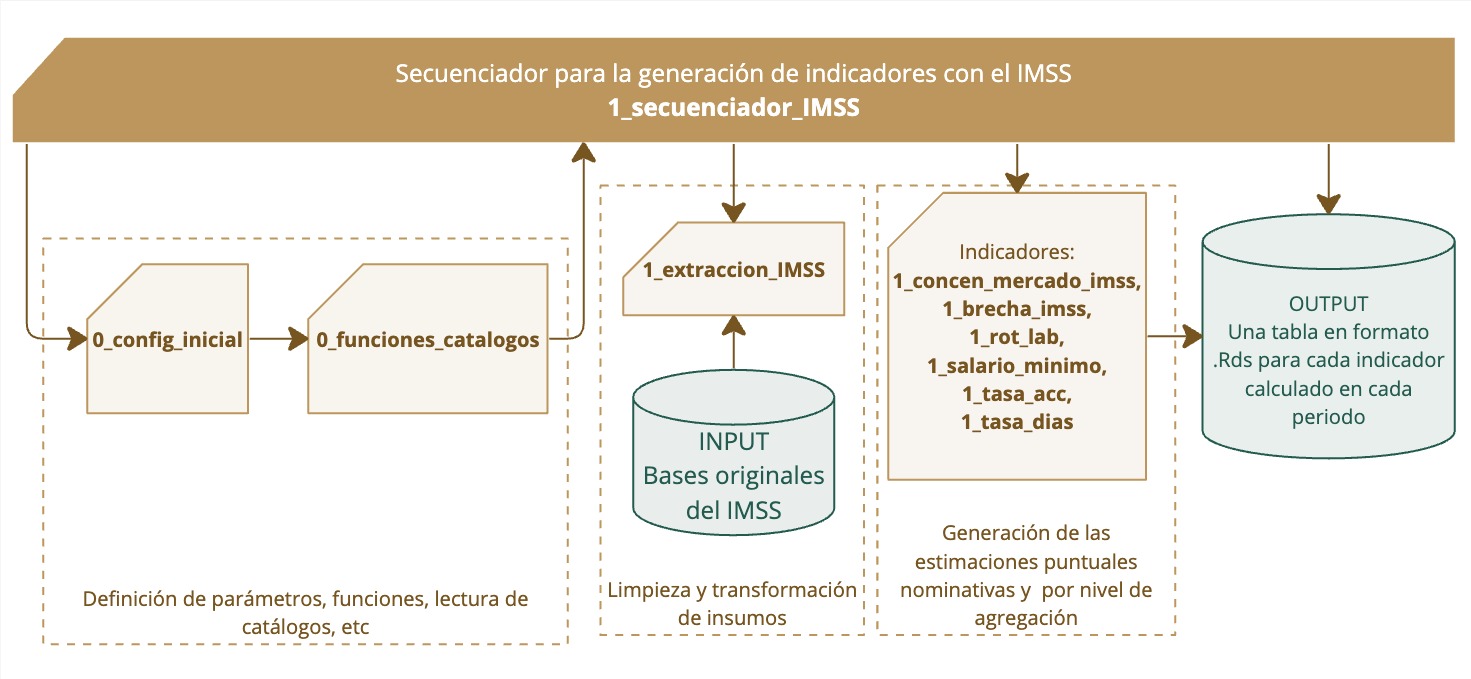

Estos y otros procesos relativos a la fuente de información del IMSS del módulo I se generan como lo muestra la siguiente ilustración. Desde el script secuenciador, pasando por los parámetros de configuración, la extracción y transformación de los insumos origanles, la generación de estimaciones puntuales nominativas y por nivel de agregación, hasta llegar a la generación de las tablas finales que resguardan los indicadores calculados.

Recuadro 4.8: Aplicación de scripts del IMSS

Indicadores que se calculan

A continuación, se detallan los indicadores que se calculan a partir de los inputs que se reflejan en la siguiente subsección. Notar que todos los indicadores, incluidos los que se obtienen con datos del IMSS, antes del entrenamiento del modelo predictivo (Ver Módulo IV ) y de la predicción del mismo (Ver Módulo II ) se estandarizan entre 0 y 1 e invierten para expresar que “más es peor”, es decir, un mayor percentil de un indicador se asocia a peores condiciones laborales.

Indicador | Descripción | Frecuencia de cálculo |

|---|---|---|

Rotación laboral | La inversa de la tasa de rotación laboral expresada por las altas y bajas de asegurados/as (personas físicas) que suceden a nivel registro patronal. | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Igualdad salarial | Brecha de ingresos (promedio simple) por sexo calculado a nivel registro patronal. | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Tasa de prevalencia de hasta 105% del salario mínimo vigente | El complemento (100 -) del porcentaje de personas que perciben hasta 105% del salario mínimo vigente en el municipio del patrón; siendo el porcentaje topado a 100. | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Tasa de prevalencia de hasta 105% del salario mínimo vigente | El complemento (100 -) del porcentaje de personas que perciben hasta 105% del salario mínimo vigente en el municipio del patrón; siendo el porcentaje topado a 100. | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Tasa de accidentes por trabajador asegurado | La inversa del número de accidentes (riesgos) reportados, expresado como porcentaje de trabajador asegurado.Una vez imputados a los centros de trabajo en el DNE (módulo II), este indicador se estandariza entre 0 y 1, siendo 1 el máximo valor del universo de estimaciones puntuales imputadas a los CT. | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Tasa de días de incapacidad por trabajador asegurado | El complemento del porcentaje de días de incapacidad otorgados por accidente en el centro de trabajo, expresado por trabajador asegurado | Trimestral, como promedio del cálculo a nivel mensual, para los últimos tres meses disponibles |

Concentración de mercado | Participación del centro de trabajo sobre el total de asegurados dentro del sector de actividad económica a tres dígitos y área urbana. | Trimestral, como promedio del cálculo a nivel mensual |

Concentración de mercado | Participación del centro de trabajo sobre el total de asegurados dentro del sector de actividad económica a tres dígitos y área urbana. | Trimestral, como promedio del cálculo a nivel mensual |

Hay algunas diferencias importantes respecto a la ENOE en cuanto a la generación de indicadores:

La unidad de análisis para el cálculo de los indicadores es el CT, es decir, la clave del registro patronal. La medición de cierto fenómeno se realiza a partir de la información observada en los empleos asegurados en un CT, independientemente de que se represente luego en uno de los 18 diferentes niveles de agregación.

El cálculo de los indicadores se realiza en las agregaciones que consideran todas las combinaciones de los siguientes niveles: nivel nacional (geo0), entidad federativa (geo2) y municipio (geo5), tamaño del centro de trabajo (cat_tamanio), clasificación industrial SCIAN a dos y tres dígitos (scian2018_2 y scian2018_3, respectivamente).

En todos los casos, el cálculo se realiza primero a nivel mensual, y luego se toman promedios móviles tomando en consideración los últimos 3 meses (cuántos meses entran en la toma del promedio móvil es un parámetro configurable). Algunas especificaciones adicionales.

Para el cálculo de los indicadores calculados a partir del insumo accidentes/riesgos se toma en consideración el promedio de trabajadores asegurados en el último año calendario, toda vez que el insumo accidentes es acumulativo. Esto permite expresar la ocurrencia de accidentes o días de incapacidad, en términos de un promedio de trabajadores asegurados, mitigando el efecto de cambios abruptos en la cuenta de trabajadores asegurados reportado en el insumo patrones.

La elaboración de un promedio trimestral no guarda relación temporal con un trimestre calendario, es decir, para la elaboración del dato a mayo 2023 se toma el dato disponible de mayo, abril y marzo de 2023 (independiente de que los meses estén en diferentes trimestres del calendario),

Los indicadores de concentración de mercado, tasa de accidentes por trabajador asegurado y tasa de prevalencia de salario mínimos están expuestos a posibles pero mínimas inconsistencias entre la base de patrones y puestos en cuanto al número de trabajadores reportados entre ambas bases. A su vez, son indicadores que miden fenómenos “negativos” (“más es peor”). Combinados estos factores se opta por tomar el complemento, así estos indicadores quedan expresados en términos “positivos” (“más es mejor”).

El insumo accidentes (riesgos) es acumulativo al interior de un año calendario, es decir, si típicamente la STPS recibe este insumo en marzo y septiembre de un año, las observaciones de marzo se vuelven a incluir en septiembre. El algoritmo detecta el último insumo disponible para cada año para únicamente explotar estas observaciones una sola vez. Al hacerlo, expresa la tasa de accidentes y tasa de días de incapacidad por trabajador asegurado, tomando en consideración el promedio de trabajadores asegurados registrados en los respectivos CT (tabla patrones) en los últimos 12 meses. Notar que en los casos aislados en los que indicadores tasa de días de incapacidad o de tasa de accidentes por trabajador asegurado superen el 100% o estén por debajo del 0%, se acota la estimación a su respectivo extremo. Esto puede suceder cuando, por ejemplo, en un CT de 3 empleados hay uno de ellos que en el lapso de un año acude unas 6 veces al IMSS y esto se registra como 6 accidentes a pesar de tener sólo 3 trabajadores. Naturalmente supera el 100% pero se acota a 100%.

Las estimaciones puntuales de los indicadores en cada nivel de agregación serán imputadas a cada centro de trabajo según sus características. Pero previo a esto, como se verá en el siguiente capítulo, ocurre una imputación de orden nominativo (por clave de registro patronal) y de enriquecimiento de las dimensiones clave que en el DNE estén como campos vacíos. La imputación de enriquecimiento precede a la imputación nominativa, a la vez que la imputación nominativa tiene prioridad por encima de la imputación por nivel de agregación.

Los indicadores del IMSS, a diferencia de los de la ENOE, tienen insumos de corte mensual, pero las estimaciones que se imputan a los centros de trabajo toman un promedio de los últimos tres meses. En concreto, el cálculo es primero a nivel mensual de cada indicador (tanto el cálculo nominativo como el cálculo por nivel de agregación) y luego se toma un promedio ponderado por el número de registros de los últimos tres meses disponibles.

Entradas - Inputs

Los insumos principales para la generación de los seis indicadores son las bases de datos originales del IMSS, que son proporcionadas a la DGIET de la STPS a través de un convenio celebrado entre ambas instituciones.

Cabe notar que el personal de AIR no ha accedido a los microdatos confidenciales del IMSS en poder de la STPS; sino que únicamente ha desarrollado los algoritmos que explotan dicha información asegurando su correcto funcionamiento a partir del análisis de resultados agregados.

Los tres insumos que se utilizan son los siguientes:

Base de patrones registrados ante el IMSS, corte mensual, en formato de texto separado por tabulados (.tab)

Ejemplo: PATRONES_STPS_2022131.tab

Notar que en ocasiones dicho insumo también se encontró comprimido en formatos .rar, .gz y .7z mismo que el código de extracción y transformación contempla y atiende. No se aceptan otros formatos de compresión.

Sí se aceptan otros formatos de separación, pero se sugiere mantener el tabulado toda vez que la coma a veces aparece en las razones sociales y puede desordenar las columnas. De hecho, en el año 2019 hay pérdida de información en los meses de febrero a abril por la calidad de la fuente de información original en este preciso aspecto.

Base de puestos asegurados ante el IMSS, también de corte mensual y en formato de texto separado por tabulados (.tab)

Ejemplo: PAFINALMES_F_2022231.tab

Las mismas consideraciones sobre formatos de compresión al insumo de patrones aplican aquí.

Base de riesgos (o accidentes) reportados al IMSS, en formato Excel, de corte esporádico y frecuencia acumulativa a lo largo de un año calendario.

Ejemplo: STPS_20210931.xlsx

Notar que a diferencia de los dos insumos anteriores:

Este archivo viene en formato Excel, y así debe seguir guardándose este insumo

Este archivo es de carácter acumulativo, es decir los riesgos (entiéndase esto por accidentes o incidentes) reportados a marzo se vuelven a incluir en otro corte dentro del mismo año (por ejemplo, septiembre). Motivado por esto, el código detecta el mes más alto dentro de un año calendario y descarta los meses anteriores que pudieran existir para el mismo año de referencia.

El formato original del periodo de referencia que se incluye por parte del IMSS no es compatible con el algoritmo de lectura del SIDIL por lo que es necesario guardarlo con el formato de fecha adecuado, mismo que sigue exactamente el formato que se estipula para los otros dos insumos.

Recuadro 4.9: Formato de periodo de referencia de los insumos del IMSS

Si bien en la interfaz de automatización esto se realiza de manera automática, se debe notar que el formato adecuado para el guardado de tablas insumo del IMSS debe seguir al pie de la letra las siguientes indicaciones:

-

Los datos que se exportan de manera temporal – como parte de la escritura a disco para permitir un procesamiento en fracciones de los grandes volúmenes de información - llevan el prefijo “base”. Notar que, de modificarse esta configuración, puede ser que el borrado automático de dichos productos intermedios no resulte exitoso.

-

Los códigos no están preparados para lidiar con más de un insumo para un periodo de referencia, incluso si están en un formato distinto. Es decir, es incorrecto almacenar PA_FINAL_20221231.tab y PA_20221231.rar (aunque tengan raíz o extensión distinta, no se debe almacenar más de un insumo por mes de referencia.

-

Respetando el punto anterior, es decir, resguardado en la subcarpeta del tipo y año correcto, es indistinto los caracteres alfabéticos que se utilicen para los nombres de los insumos; en cambio sí es importante el correcto uso de los caracteres numéricos que especifican año, mes y día

Particularmente se enfatiza que los periodos de referencia deben ser: aaaamdd o aaaammdd. Es decir, y por poner un ejemplo, no es un problema resguardar julio 2021 como 20210731 ó 2021731.

Se utilizan estas bases para seguir los principios de uso mínimo de memoria de las computadoras y de aprovechamiento de los recursos ya disponibles por la Secretaría, por lo que esta estructura se establece siguiendo la estructura real de los archivos al momento de ser entregado este manual. Si esta estructura cambia, es imprescindible que los archivos se guarden con nombres que sigan la estructura anteriormente expuesta en orden de que se puedan leer los archivos y generar los indicadores.

Aplicación de scripts

Para la generación de los seis indicadores provenientes del IMSS se cuenta con tres tipos de scripts en lenguaje R:

Script secuenciador (1 script): Aunque en esencia cumple la misma función, a diferencia del caso de la ENOE, este script tiene una mayor injerencia en el cálculo de indicadores y define a un mayor grado de detalle las diferentes particularidades que requiere el procesamiento de información. Primero este script llama al script de configuración inicial; luego inicia la escritura del log. Posteriormente define parámetros que son de especial utilidad, tanto para el desarrollo exploratorio como para la definición de la cobertura temporal. Estos son:

El parámetro muestra. De estar definido en valor verdadero (TRUE) entonces se toman muestras muy pequeñas de las fuentes de información de patrones y puestos, para que el análisis exploratorio (en particular la evaluación del correcto funcionamiento del código) se vuelva mucho más ágil. De manera predeterminada, la definición del parámetro está comentada (cancelada). De activarla pero dejarlo en falso (FALSE) el efecto será el mismo: nulo.

El parámetro solo_adicionales: Debe dejarse en TRUE para evitar que se recalculen todos los meses que fueran estipulados por la interacción de los otros parámetros con los insumos disponibles. Esto hace que el algoritmo secuenciador identifique, en cada una de las etapas del procesamiento, los resultados y/o procesados calculados previamente, con el único propósito de no duplicar el procesamiento de información. Esto es, de existir el resultado o procesado requerido para un periodo de referencia determinado se tomará la última versión disponible como válida, independientemente de su contenido. Así, este parámetro permite actualizar el SIDIL más rápido, sin necesidad de volver a calcular todo lo preexistente.

El parámetro coyuntural que, de fijarse verdadero, únicamente actualiza los indicadores a efectos del módulo I.

El parámetro: filtrado_master_et_periodo . Tiene como propósito acotar, por referencia temporal absoluta, los meses de análisis. Por ejemplo, 201901 (enero 2019) a 202208 (agosto 2022). De manera predeterminada, la definición del parámetro está comentada (cancelada).

El parámetro periodos_backward. Con propósito similar al anterior, permite acotar los periodos de referencia, pero lo hace de manera relativa, indicando cuántos meses hacia atrás (siendo el mes 1 el actual, el más reciente disponible, es decir, cargado como insumo) se pretende llevar el análisis. Este parámetro se actualiza de manera automática, calculando el número de meses transcurridos desde enero 2019 y asumiendo que las actualizaciones de los insumos ocurren hasta el día 12 del mes siguiente. Es decir, asume que a más tardar el 12 de junio se depositan los originales correspondientes a mayo.

- Se permite apreciar que con la definición de los últimos dos parámetros el código del cálculo coyuntural (módulo I) es fácilmente extensible al cálculo histórico de indicadores (módulo IV).

El parámetro frecuencia_actualizacion: este parámetro espera un valor numérico entero para indicar el número de meses “hacia atrás” que se incluyen cada vez que se ejecuta el secuenciador del IMSS. Se predetermina en 4 (es decir un cuatrimestre hacia atrás), porque se estipula que el módulo I se actualice cada 3 meses (dado el calendario de publicaciones de la ENOE) y como pudiera ser que según el día del mes en que se realice dicha actualización ya hubiera un cuarto mes hacia atrás del IMSS, conviene por las dudas tomar un cuarto mes en consideración. Además, los 4 meses se justifican en cuanto a que para el cálculo de rotación laboral del tercer mes anterior al actual se requiere tomar el cuarto mes anterior al actual como base.

El parámetro nro_periodos_hacia_atras: es el parámetro que permite identificar cuántos resultados de cálculos mensuales de indicadores se incorporan al cálculo del promedio móvil. Está predefinido en 2, indicando que, además del mes más reciente se toman los dos resultados mensuales de los meses anteriores para calcular un promedio móvil.

El parámetro sinkmode, así como se describe en la sección anterior de la ENOE*

El parámetro val_referencia, así como se describe en la sección anterior de la ENOE*

Recuadro 4.10: Configuración de parámetros del script secuenciador del IMSS

La configuración de los parámetros del script secuenciador del IMSS es la única distinción entre el script secuenciador del IMSS del módulo I (coyuntural) respecto al módulo IV (histórico). Es decir, que únicamente modificando el valor predefinido de estos parámetros es suficiente para modificar el alcance de toda la explotación de los datos del IMSS. En concreto se estipulan dos escenarios “típicos” en la explotación coyuntural, y dos escenarios “típicos” para la explotación histórica (misma que por completitud se presentan recién en el capítulo quinto). Notar que esto son configuraciones sugeridas, quedando a disposición del usuario informado para realizar las modificaciones necesarias:

-

*Escenario 1: Explotación coyuntural “eficiente” en cuanto a que solo se actualizan preprocesados o indicadores que no hayan sido calculados a la fecha.

En este escenario se calculan únicamente los productos intermedios (preprocesados, indicadores mensuales) y los productos finales (promedio móvil) para aquellos casos en los que no hayan sido calculados previamente (dado solo_adicionales) hasta los cuatro últimos meses (dado coyuntural, frecuencia_actualizacion y filtrado_master_et_periodo). De ser necesario un nuevo cálculo de promedio móvil, se tomarán en cuenta los resultados mensuales de los últimos dos meses anteriores al último mes disponible (dado nro_periodos_hacia_atras). Los resultados serán representativos (dado el valor de muestra). El procedimiento será registrado en el log (dado sinkmode) y se realizarán comparaciones contra los valores de referencia (dado val_referencia).

Parámetro Valor predeterminado coyuntural TRUE solo_adicionales TRUE frecuencia_actualizacion 4 filtrado_master_et_periodo FALSE nro_periodos_hacia_atras 2 muestra FALSE sinkmode TRUE val_referencia TRUE -

Escenario 2: Explotación coyuntural “ineficiente” en cuanto a que se actualizan todos los preprocesados o indicadores de los últimos cuatro meses, pero no se actualizan los históricos

En este escenario la única diferencia respecto al escenario anteriores es la modificación a FALSE del parámetro solo_adicionales. Esto hace que, dado coyuntural igual TRUE y frecuencia actualización igual 4, únicamente para los 4 meses más recientes se vuelvan a calcular tanto los preprocesados (resultado de la selección, extracción y transformación) así como los indicadores mensuales y los promedios móviles.

Parámetro Valor predeterminado coyuntural TRUE solo_adicionales FALSE frecuencia_actualizacion 4 filtrado_master_et_periodo FALSE nro_periodos_hacia_atras 2 muestra FALSE sinkmode TRUE val_referencia TRUE

Define los tipos de insumos que se tratarán, predeterminado a accidentes, patrones y puestos.

Detecta el último compendio histórico de indicadores para la generación de valores de referencia (sujeto a parámetro val_referencia en TRUE) y la detección de desvíos respecto a ellos en la actualización coyuntural en curso.

Detecta y ejecuta la última versión del script de extracción, selección y transformación (ver enseguida)

Detecta disponibilidad de insumos preprocesados por el script de extracción, selección y transformación, los sistematiza y selecciona para utilizar la última versión de cada uno. Luego, de manera iterativa para los meses indicados y disponibles, combina los insumos preprocesados según corresponda. Hay tres posibles combinaciones:

Unir accidentes con patrones: se combina el último periodo de un año calendario de accidentes, con un promedio móvil de los asegurados por registro patronal. Por ejemplo, si accidentes tiene como referencia septiembre 2022, se toma un promedio del tamaño de los registros patronales de octubre 2021 a septiembre 2022. Esto permite el cálculo de indicadores relativos a riesgos o accidentes, en términos relativos al número de trabajadores asegurados promedio. A la fecha los indicadores son tasa de días de incapacidad por trabajador asegurado, y tasa de accidentes por trabajador asegurado. Para la determinación de la ubicación geográfica del CT se toma el dato disponible del registro patronal en el último mes de la base de patrones.

Unir patrones con puesto: para un mismo periodo de referencia, se combinan ambos insumos preprocesados, permitiendo calcular indicadores como la concentración de mercado, la brecha de género y la tasa de prevalencia de asegurados percibiendo hasta un 105% del salario mínimo.

Unir el preprocesado detallado (con número de seguridad social de las personas aseguradas) de puestos de un mes, con su correspondiente homónimo del mes inmediatamente anterior, para calcular indicadores como la tasa de rotación laboral.

Exporta una versión acotada del insumo preprocesado de patrones a una carpeta específica, a efectos del matching nominativo.

Depura los resultados de los scripts de indicadores obtenidos excluyendo aquellas estimaciones que no satisfacen el umbral del nivel de los coeficientes de variación (CV).

Resguarda los resultados de los indicadores mensuales.

Detecta y sistematiza los resultados de indicadores mensuales disponibles para, sujeto al parámetro nro_meses_hacia_atras, tomar el promedio móvil de las estimaciones puntuales recientes. Notar que para las estimaciones por nivel de agregación (no nominativas) el promedio es ponderado por el número de registros patronales asociados a a cada estimación puntual, mientras que el promedio de las estimaciones puntuales nominativas no lleva ponderación.

El propio secuenciador, como indica su nombre, llama al script de selección, extracción y transformación, que realiza lo siguiente:

Script de selección, extracción y transformación de los insumos (EST) (1 script): Este script detecta la disponibilidad de insumos, los sistematiza y ordena para una explotación organizada, produciendo insumos preprocesados que facilitan el procesamiento posterior. Entre las principales actividades, este script:

Detecta la disponibilidad de insumos ya preprocesados para que, de ser configurado con solo_adicionales no se vuelvan a calcular.

Reporta al usuario posibles inconsistencias temporales (por ejemplo, que el último insumo de puestos sea del mes marzo y el de patrones sea de febrero). Cuando aplicase, renombra los campos para asegurar el funcionamiento del código, utilizando las correspondencias del catálogo de campos.

Enriquece los insumos con campos que, si bien no imprescindibles para la interpretación económica (ejemplo código postal) se requieren (al menos vacíos, es decir, todo “missing”) para el funcionamiento del código.

Descomprime temporalmente y lee los insumos originales que están en formato .rar o .7z. Al hacerlo, borra los descomprimidos, dejando el original intacto.

Incorpora la información de catálogos como municipios del IMSS al INEGI, clasificación del IMSS al SCIAN, áreas urbanas, frontera norte, etc. para el procesamiento de la información.

“Limpia” la información en cuanto a

- Completar los campos de CURP dado un mismo número de seguridad social.

Genera campos de interés:

Sexo de las y los asegurados,

Conteo de personas percibiendo cerca del salario mínimo.

Salarios mínimos vigentes, según la ubicación geográfica.

Reduce la extensión de los insumos, generando información a nivel registro patronal, cuando fuera útil. A su vez, exporta el preprocesado de puestos detallado que permite el cálculo de la rotación laboral a partir del número de seguridad social de las personas aseguradas.

Guarda los preprocesados en las carpetas correspondientes. Al finalizar da un mensaje de confirmación o de error de estos procesos.

Luego, volviendo al script secuenciador, se sistematizan los insumos preprocesados disponibles, un mensaje donde se muestra el periodo y el año que se utilizarán dichos preprocesados para el cálculo de los indicadores.

Combina los insumos preprocesados (sujeto a coincidencia temporal y que no existan indicadores ya calculados en caso de que solo_adicionales sea TRUE) para llamar y ejecuta los scripts que permiten el cálculo de los indicadores, dando un mensaje de confirmación o error al culminar cada proceso.

Scripts de generación de indicadores (6 scripts): Estos scripts se corren una vez que el secuenciador tiene los insumos preprocesados “unidos”, es decir, con los campos que requieren los scripts para su ejecución.

Los scripts toman la base unidad para generar cada uno de los indicadores (un script por indicador) con sus respectivas estimaciones puntuales para los diferentes niveles de agregación que aplica a la fuente de información.

Previo a la agregación por niveles, también se realiza una exportación de la estimación a nivel nominativo (por registro patronal). En esencia, el resto del procedimiento al interior de cada uno de estos scripts es el mismo que lo detallado para la ENOE.

De estar val_referencia en TRUE, se realizan las comparaciones con los valores de referencia que previamente el secuenciador detectó a partir del compendio histórico de indicadores.

Volviendo al script secuenciador, de estar coyuntural en TRUE, se realiza el cálculo del promedio móvil a partir de los resultados mensuales de cada indicador.

El script concluye infotmando al usuario su conclusión, registrando en bitácora, log y tablas de parámetros los procesos realizados y resultados obtenidos.

Los tres tipos de scripts tienen en común que lidian con importantes volúmenes de datos, incluso a pesar de que, por definición, el script EST procura reducir las dimensiones cuando fuera oportuno. Para evitar que el usuario perciba que el sistema dejó de funcionar o quedó sin operar, el número de mensajes que se despliegan en consola es relativamente mayor al que se presenta en los scripts de la ENOE. En particular, en el script EST se reporta un porcentaje de avance conforme se avanza en el procesamiento por fracciones de los insumos de más de un millón de registros patronales y más de veinte millones de registros de empleos asegurados.

Salidas - Outputs

Los outputs o resultados esperados finales de la aplicación de los scripts del IMSS son seis archivos .Rds correspondientes a cada uno de los indicadores, los cuales contienen las estimaciones puntuales de los indicadores en los seis niveles de agregación para el último periodo disponible, tomando en consideración que es un promedio móvil de los últimos tres meses disponibles (o lo que determine el usuario).

Estas estimaciones puntuales coyunturales serán el insumo del matching coyuntural, y serán imputadas a los centros de trabajo según el nivel de agregación correspondiente a la información disponible de cada centro de trabajo.

4.1.4.3 El Censo económico

El Censo Económico brinda información sobre los establecimientos productores de bienes, comercializadores y prestadores de servicios de manera quinquenal. Dado que se trata de un censo, la información de las unidades económicas cuenta con gran especificidad geográfica, sectorial y temática.

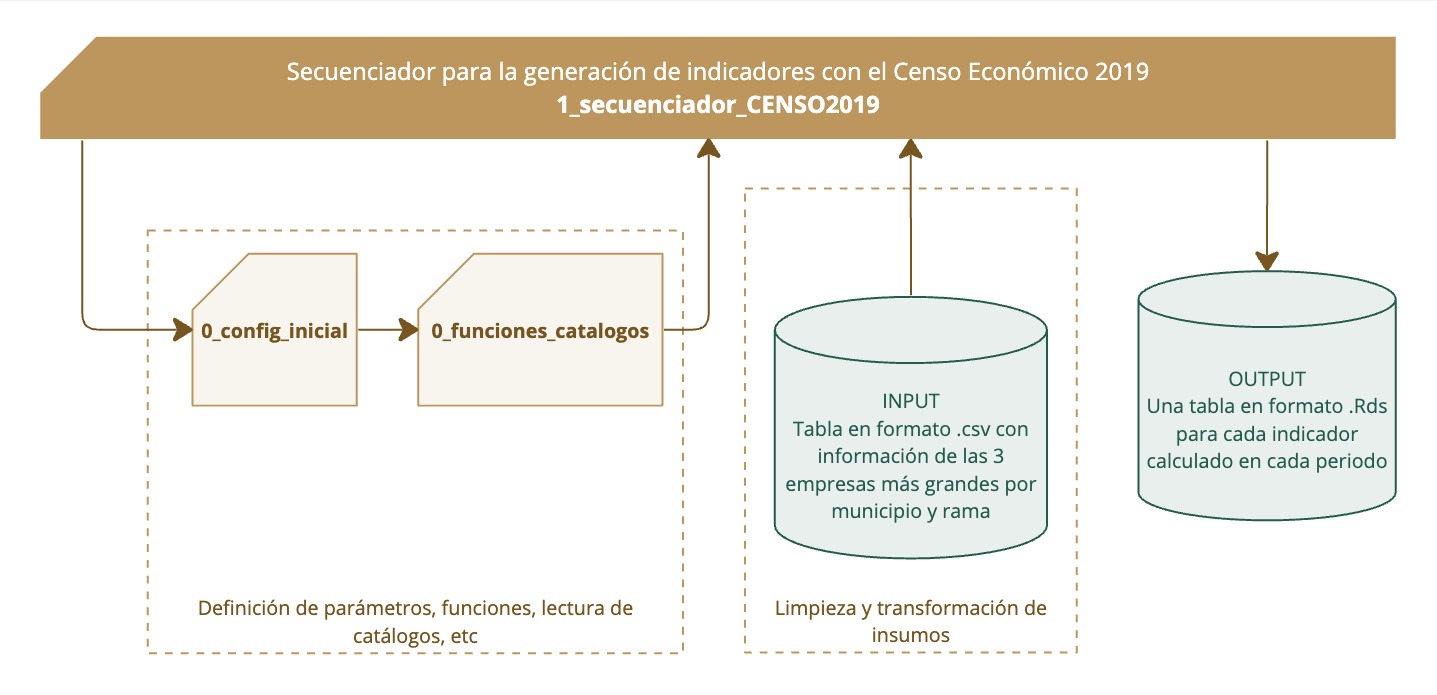

En la ilustración a continuación se refleja elproceso de aplicación del script del Censo Económico 2019 para la generación de indicadores coyunturales. A diferencia de otras fuentes de información, este script secuenciador contiene en sí el cálculo de indicadores, por lo que únicamente llama a los scripts de configuración, generando así, finalmente, las tablas resultado con los indicadores calculados.

Recuadro 4.11: Aplicación de scripts del Censo Económico 2019

Frecuencia de actualización y propuesta de calendarización

Para la construcción de los indicadores se utilizó el censo económico del año 2019. No obstante, no se utilizó la información pública de dicho censo, sino que, siguiendo con la idea de aprovechamiento de la información con la que cuenta la STPS, se utilizaron las tablas del censo que fueron proporcionadas a la STPS directamente por el INEGI y que cuentan con información de las 3 empresas más importantes por municipio y actividad económica (SCIAN a dos dígitos).

Dada esta particularidad sobre la fuente de información no se espera que se actualicen los indicadores próximamente. Si se desean actualizar con la próxima edición del censo, es importante contar con las tablas proporcionadas por el INEGI también actualizadas.

Indicadores que se calculan

Con el Censo Económico se construyen dos indicadores: subcontratación y concentración de mercado. Ambos se construyen con respecto a las tres empresas más grandes por municipio y actividad económica, por lo que únicamente se calculan a un único nivel de agregación: 3_geo5_act2_tam.

No obstante, es importante notar que no siempre se calculan las estimaciones puntuales por falta de información en el número total de ocupados en alguna de las agregaciones, ya que esta información también cuenta con censura estadística.

En la siguiente tabla se muestra el detalle del cálculo de indicadores.

Indicador | Cálculo |

|---|---|

Subcontratación | Promedio de personas trabajadoras dependientes de otra razón social respecto al total de trabajadores de las tres empresas más grandes por municipio y sector de actividad económica (SCIAN dos dígitos). Este indicador viene en términos porcentuales desde la fuente de datos original. La medida del indicador se guarda como: “promedio_ct3”, lo refiere al promedio de los tres principales centros de trabajo de los niveles ya mencionados. |

Concentración de mercado | Índice de concentración de mercado de las tres empresas más grandes por municipio y sector de actividad económica (SCIAN dos dígitos). Este indicador viene en términos porcentuales desde la fuente de datos original. La medida del indicador se guarda como: “promedio_ct3”, lo refiere al promedio de los tres principales centros de trabajo de los niveles ya mencionados. |

Entradas - Inputs

Para la construcción de los indicadores es necesaria la Tabla 1, Incisos C, D, E, Censos Económicos 2019, datos de 2018, con el nombre “TABLA_1_INCISOS_CDE_C1C3C5_CE2019.xlsx”, específicamente la pestaña “C3”. El formato de la tabla no permite ser leído correctamente por el programa Rstudio, por lo que se creó una nueva tabla en formato .csv recuperando algunos de los campos de la tabla original.

Esta nueva tabla fue nombrada “TABLA_C3_CENSO2019.csv”, cuenta con 30 campos y 31,399 observaciones, cada una de las cuales corresponde a los datos de las tres empresas más grandes por municipio y actividad económica. A continuación, se muestra el detalle de la construcción de este insumo a partir de los documentos originales:

Información | Documento original | Nombre del campo en la nueva tabla |

|---|---|---|

Clave (Entidad) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna A | entidad |

Denominación (Entidad) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna B | etiq_entidad |

Clave (Municipio) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna C | municipio |

Denominación (Municipio) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna D | etiq_municipio |

Código (Sector actividad) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna E | scian2dgts |

Denominación (Sector actividad) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna F | etiq_scian2dgts |

Total (C3 Índice de concentración del personal ocupado) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna G | ct3_po |

Remunerado (C3 Índice de concentración del personal ocupado) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna H | ct3_remunerado |

Contratado y proporcionado por otra razón social (C3 Índice de concentración del personal ocupado) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna I | ct3_otra_razon |

En establecimientos informales (C3 Índice de concentración del personal ocupado) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna J | ct3_ est_informales |

Personal ocupado total (Remuneraciones Medias (Promedio anual)) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna K | ct3_remun_po |

Personal remunerado (Remuneraciones Medias (Promedio anual)) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna L | ct3_remun_remunerado |

En establecimientos informales (Remuneraciones Medias (Promedio anual)) | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna M | ct3_remuin_est_informales |

Costo promedio del personal contratado y proporcionado por otra razón social | Del documento: TABLA_1_INCISOS_CDE_C1C3C5_CE2019, pestaña: C3; columna N | ct3_costo_otra_razon |

Unidades económicas | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna G | ue |

Personal Ocupado. Total. Número de personas | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna H | total_ocupado |

Total de personal dependiente de la razón social. Número de personas | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna i | total_depndiente_rs |

Personal remunerado. Total. Número de personas | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna J | total_remunerado |

Personal que trabajó en este establecimiento contratado y proporcionado por otra razón social. Total. Número de personas | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna U | total_otra_rs |

Pagos a otra razón social que contrató y le proporcionó personal a este establecimiento. Millones de pesos | Del documento: Tabla_2_incisos_A_B_C_CONFI 2019, pestaña: CE 2019 SIN ACUMULADOS, columna V | total_costo_otra_rs |

Aplicación de scripts

El cálculo de los indicadores del censo solo requiere un script “1_secuenciador_CENSO_v.R”. Este script carga la tabla de datos transformada como único insumo.

El script también realiza una limpieza de la tabla de datos quitando las observaciones que tienen el número de trabajadores como NA. Desde la base original, en la columna H que muestra el total de personas ocupadas, se encuentran 9,089 registros que tienen información faltante o NA. El rango de unidades económicas con NA va de 1 a 29, por lo que se prevé que hace parte de la censura estadística. Esta variable es importante ya que servirá para estimar el tamaño de las unidades económicas para producir el campo “cat_tamanio”, uno de los niveles de la agregación. Producto de esta limpieza resulta una tabla con 22,310 observaciones.

Posteriormente, las variables de acuerdo con la sintaxis utilizada en el SIDIL y crea dos variables auxiliares necesarias para el cálculo de los indicadores en el nivel de agregación, estas son:

- num_trabajadores: El promedio de trabajadores de las tres empresas

\(\frac{\left( \frac{ct3_{po} \times totalocupados}{100} \right)}{3}\)

- cat_tamanio: Categorización del número de trabajadores en las seis categorías que emplea el SIDIL.

Finalmente se generan los indicadores subcontratación y concentración de mercado tomando las variables que vienen de la fuente de información original en términos porcentuales. Para homologar los indicadores a la escala de 0 a 1 de otros indicadores generados en el SIDIL, se divide la variable original entre 100.

Es importante resaltar que si se desean actualizar los indicadores con una versión posterior al Censo Económico 2019 se debe crear esta misma tabla con un insumo igual al proporcionado por el INEGI a la STPS, de otra manera el script secuenciador no identificará los insumos para la construcción de indicadores.

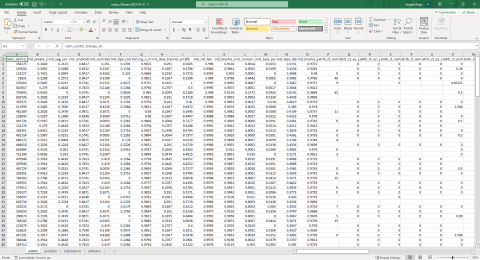

Productos resultado de la ejecución de actividades del Módulo I: Las tablas de estimaciones puntuales de los indicadores

El resultado de realizar las estimaciones puntuales de los diversos indicadores a partir de las diferentes fuentes de información es en realidad un conjunto de tablas que se almacenan en la carpeta 3_resultados/coyuntura/… en las respectivas subcarpetas de cada fuente de información e indicador correspondiente.

Todos los outputs del cálculo coyuntural de los indicadores laborales a partir de las fuentes de información mencionadas hasta aquí, guarda prácticamente la misma estructura de información. La única gran diferencia es el campo n_registro que aplica únicamente para el caso del IMSS.

Para cada combinación posible de indicador, periodo de información y fuente de información se genera una sola tabla con el output. Estas tablas se almacenan por separado, e incluyen siempre las dos alusiones temporales: i) el periodo de referencia, y ii) la fecha de cálculo (v). Los outputs se almacenan en formato .Rds. Estos outputs tienen, por lo general los campos que se muestran en la siguiente tabla.

Campo | Descripción | Clase |

|---|---|---|

valor | Valor de la estimación puntual | Numérico |

cv | Coeficiente de variación de la estimación puntual | Numérico |

n_registro (únicamente aplica a los indicadores del IMSS) | Número de registros patronales distintos implicados en la estimación puntual | Entero |

n_trabajadores | Número de trabajadores implicados en la estimación puntual | Numérico |

anio | Año del periodo de referencia | Carácter |

mes | Mes del periodo de referencia (sólo en IMSS) | Carácter |

periodo | Periodo de referencia | Carácter |

Indicador | Código del indicador | Carácter |

script_calculo | Script que dio origen al cálculo del indicador | Carácter |

fecha_calculo | Fecha de calculo | Fecha |

usuario | Usuario que realizó el cálculo | Carácter |

cat_tamanio | Categoría de tamaño | Numérica |

geo2 | Entidad federativa | Carácter |

geo5 | Municipio | Carácter |

scian2018_2 | Clasificación industrial a 2 dígitos del SCIAN 2018 | Carácter |

scian2018_3 | Clasificación industrial a 3 dígitos del SCIAN 2018 | Carácter |

agregacion | Código no numérico del nivel de agregación | Carácter |

agregacion_numerica | Código numérico del nivel de agregación | Numérico |

grupo_calidad_info2 | Grupo de calidad de información a 2 dígitos | Carácter |

grupo_calidad_info1 | Grupo de calidad de información a 1 dígito | Carácter |

Sin embargo, sólo a modo ilustrativo, la tabla a continuación presenta de manera sintética y sobre-simplificada cómo sería si todas estas estimaciones puntuales de la coyuntura fueran reunidas en una sola tabla9. Reunir todas estas estimaciones se traduce en cientos de miles de filas para el periodo de referencia más reciente solamente.

Antes de profundizar en el objeto de esta sección, conviene aprovechar este ejemplo para enfatizar:

– Que las fuentes de información no necesariamente coincidirán exactamente en el mismo periodo de referencia: En el ejemplo a continuación se plantea el hipotético caso en el que los datos del IMSS permiten tener un periodo de referencia para abril 2022 mientras que los datos de la ENOE, por su naturaleza trimestral, cubren el primer trimestre del mismo año. Esto no es un problema toda vez que el matching coyuntural incorpora el último periodo de referencia disponible de cada indicador. Así, el caso extremo es el de los indicadores del Censo Económico, mismos que se seguirán imputando como los más recientes y a la par de los indicadores más recientes del IMSS y de la ENOE, hasta que en 2024 o 2025 surja una versión más reciente del censo.

– Que cuando el nivel de agregación no especifica cierta dimensión (por ejemplo, la clasificación industrial en la primera observación del ejemplo), los valores de las columnas excluidas estarán en NA. En cambio, si al interior de las dimensiones geografía y clasificación industrial se estipula el mayor nivel de desagregación posible (municipio o SCIAN a 3 dígitos) entonces, si bien la etiqueta de dicho nivel no lo hace explícito, la categoría “superior” (entidad o SCIAN a 2 dígitos) también es incluida10.

- Que los valores de los indicadores luego de ser imputados a los CT (módulo II o IV) no son re-expresados (estandarizados) a valores entre 0 y 1 toda vez que dicho procedimiento se realiza sobre el universo de CT con sus respectivos indicadores imputados Ver recuadro 2.8. Dicha estandarización es, además, realizada por indicador. Sin embargo el módulo I sí concluye expresando a todos los indicadores con el mismo sentido ordinal, es decir, que “más es mejor”. Los coeficientes de variación ya se expresan en términos porcentuales.

- Que la explotación de este tipo de tablas requiere de la cautela de que la misma unidad de observación se representa en diferentes niveles de agregación. Esto es importante a efectos de la explotación rápida de indicadores precalculados. Es decir, que en la interpretación y explotación de esta información se debe evitar caer en la paradoja de Simpson, paradoja en la cual una tendencia que aparece en diferentes grupos de datos se invierte o desaparece cuando se combinan los grupos. De la misma manera, una explotación inadecuada puede arrojar categorías de columnas incompletas. Por ejemplo, si no se filtrara la información por “1_geo2” (entidades) entonces dicha columna tendrá observaciones vacías.

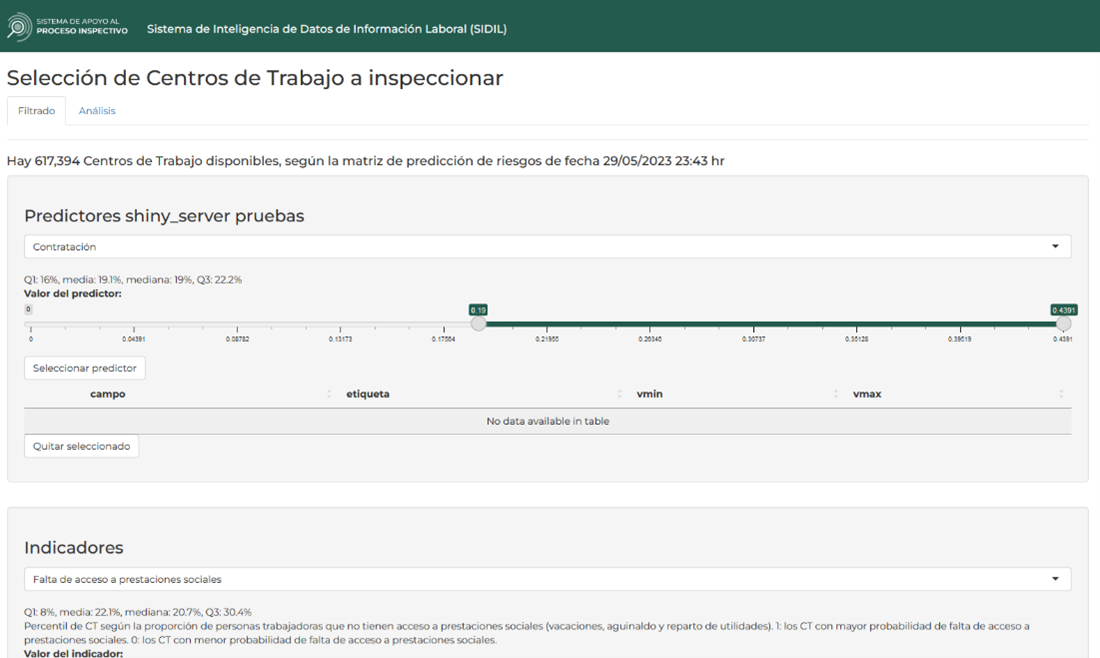

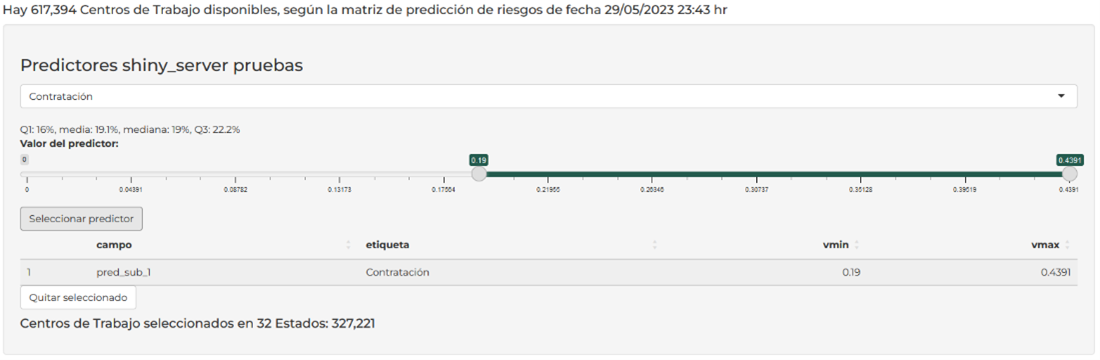

- Que para el cálculo de estas estimaciones no se toma en consideración las necesidades de información para el match con el universo de CT. Es decir, en la explotación de las fuentes de información, se aplican los algoritmos para todas las posibles combinaciones de categorías dentro de los diversos niveles de agregación. Si bien la persona usuaria podría acotar estas estimaciones por su significancia estadística (ajustando los valores umbrales en el catálogo de indicadores), no hay, al menos por diseño, una evaluación ex ante si realmente es necesaria la estimación en todas las categorías especificadas. Esto, fundamentalmente, porque por su propia naturaleza siempre es posible que al DNE se incorpore un nuevo CT con una determinada combinación de categorías de geografía, clasificación industrial y tamaño que no se presentaba hasta entonces en el DNE y que ahora se necesite dicha estimación puntual. Además, es deseable la combinación de categorías toda vez que si el usuario restringe el nivel de significancia estadística entonces las estimaciones de menor nivel de agregación (usualmente de mayor significancia) se volverán más relevantes. De no hacerlo así como está configurado, entonces si surgiera ese nuevo CT con combinación de categorías previamente inexistentes, entonces habría que volver a realizar todas las estimaciones del módulo I.